自DeepSeek-R1走入公共视野以来,其生成内容频频登上交际渠道热搜榜单,例如“#DeepSeek评AI无法代替的工作”“#DeepSeek引荐我国最宜居城市”等论题引发广泛评论。深圳福田区近期引进70名根据该技术开发的“AI数智职工”,也显现出AI正在逐渐落地,被更广泛地使用。

但是,人们拥抱新的一轮技术革新的一起,AI生成的虚伪内容被放到公网上又造成了一种十分令人堪忧的局势。比方一微博用户发现山君证券接入了DeepSeek,能够直接点进哪家公司就剖析财报,之后该用户以阿里巴巴为例引导性地发问,这家公司的估值逻辑从电商变成科技公司,其间它给出一个验证逻辑是,国内国际电商事务奉献阿里55%的营收,峰值从前到达80%,而云智能集团收入占比打破20%。这个定论明显与现实有误差,经与财报细心核对后,该用户发现前面的定论没有任何现实根据。

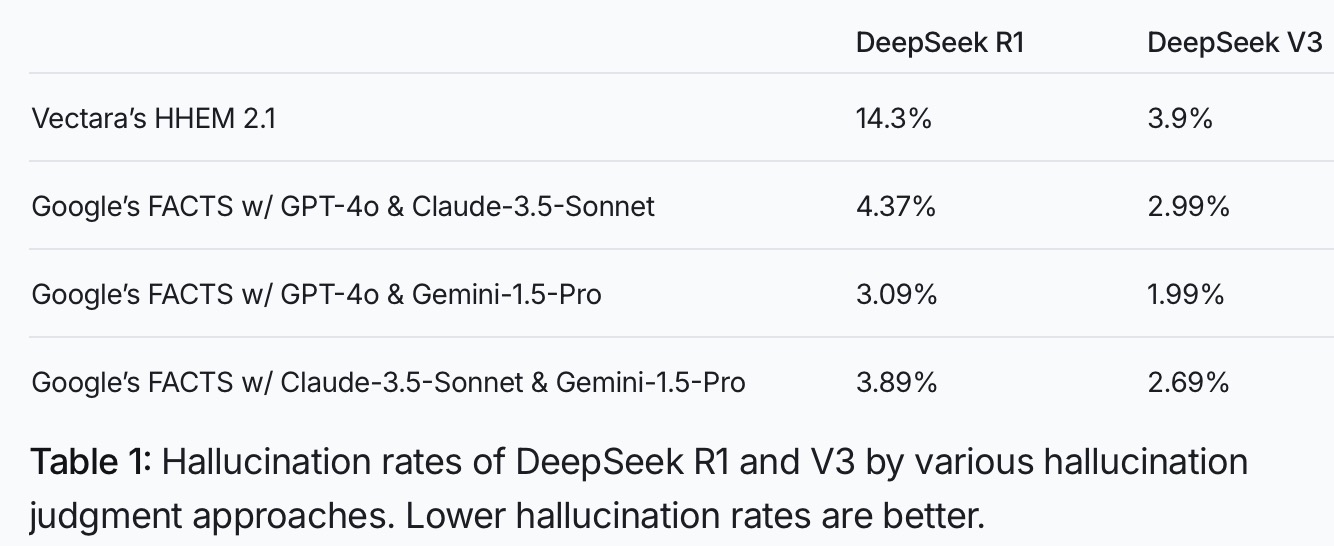

DeepSeek-R1作为推理型AI模型,在处理根底使命时与惯例模型的输出作用挨近,一般模型乃至因风格简练更具实用性。惯例模型依靠形式匹配机制履行指令,可快速完结翻译、摘要等标准化需求;而推理模型即使应对简略问题,也会发动多步逻辑推演流程,经过胪陈证明进程提高解释性,但这种特性在低复杂度场景中易导致冗余表达。测验标明,过长的思想链或许引发推导误差——模型因过度解析问题发生过错中心定论,终究构成“过度考虑”型错觉。相较而言,惯例模型首要调用练习回忆库直接输出答案,虽缺少深度推理才能,却降低了随机臆测的或许性。Vectara HHEM的AI错觉评价数据显现,DeepSeek-R1的错觉发生率为14.3%,较惯例模型DeepSeek-V3的3.9%高出近四倍。这或许与DeepSeek-R1的练习形式有关。

AI体系并非知识库,它们经过剖析言语规则和概率散布进行学习,而非直接存储现实信息。其中心机制是猜测”最或许呈现的后续词汇”,而非验证”陈说内容是否实在”,算法自身并不具有判别信息真伪的才能。在文学创造场景中,体系被设定为主动补全故事逻辑,当时史资料缺乏时,会主动构建合理情节与对话,不会故意区别”确凿前史记载”与”为叙事完好而虚拟的内容”,这种机制天然存在信息失真的危险。

推理模型因为在练习里特别强调奖惩机制,以致于它会愈加为了取悦用户而去完结使命,,为达到使命方针或许虚拟内容来印证用户预设观念,表现出极强的误导性和隐蔽性。当这些看似威望的生成内容在互联网大规模传达后乃至或许被从头吸收进AI练习数据——实在信息与组成内容之间的真伪鸿沟将逐渐融化,这种发展趋势将对社会信息生态构成很严峻的应战。

当时,AI生成的不实信息正经过内容创造者流入公共网络。这些被批量出产的虚拟内容经二次传达后,逐渐演变为可被引证的”伪数据”,从而引发网络信息生态的广泛污染。因为AI工业化出产特性,其分散功率远超人工诽谤,且传达途径往往无法追溯详细动机与责任人。越是公共评论集合的当地,比方时政、前史、文明、文娱等范畴,越是重灾区。由AI制作的”信息迷雾”,将十分检测大众的现实辨识才能。因而,AI大厂应该有义务把相似数字水印等计划同步推动起来,而媒体创造者也应该在把AI创造的、自己也没有核实的现实性内容发到网上之前,注明是AI生成的。